Algorytmy mylą się. I to bardzo.

źródło: Future Wake

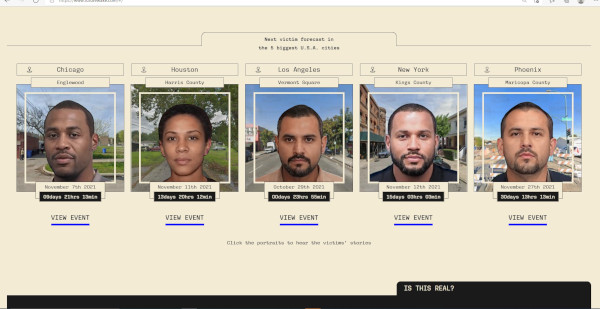

Co by było, gdyby sztuczna inteligencja mogła przewidzieć, kogo policja zabije w następnej kolejności? To przewrotne pytanie zadali sobie holenderscy artyści Oz i Tim (ze względu na kontrowersyjność ich pracy zachowują anonimowość). Tak powstał projekt „Future Wake”, nagrodzony właśnie nagrodą Mozilla Creative Media, wspierającą tworzenie godnej zaufania sztucznej inteligencji.

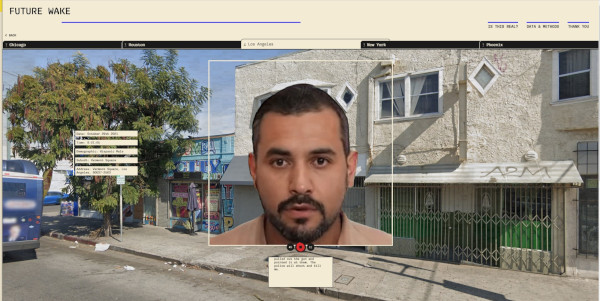

Artyści opracowali interaktywną witrynę, na której widzowie mogą odwiedzić pięć najbardziej zaludnionych amerykańskich miast: Houston, Chicago, Los Angeles, Phoenix i Nowy Jork. Oz i Tim użyli systemu sztucznej inteligencji stosowanego w systemach predykcyjnych policji do typowania sprawców przestępstw, lecz tym razem wycelowali go w odwrotnym kierunku, przewidując, kto w tych metropoliach najprawdopodobniej zostanie zabity przez policję. Co więcej: pokazali, gdzie to się stanie i w jaki sposób ofiara straci życie. Potencjalne historie są przedstawione w szczegółach w zaskakujący sposób: widzimy i słyszymy ofiarę omawiającą swoje doświadczenia i śmierć. Przed oczami mamy nie tylko jej imię, nazwisko, zdjęcia, dokładną datę śmierci, ale też zegar odliczający czas do prognozowanej akcji policji, w której ta osoba ma zginąć.

źródło: Future Wake

W ten sposób artyści chcieli podkreślić, że ofiary to coś więcej niż tylko statystyki – ich twarze są pokazane, a głosy zostały „podarowane” przez prawdziwą osobę. – Trudno wczuć się w liczbę; dużo łatwiej jest wczuć się w ludzką twarz – mówi Oz.

Future Wake nie tylko wywraca koncepcję działania policji opartego na predykcyjnych systemach zasilanych sztuczną inteligencją, ale też jest hołdem dla tych, dla których spotkania z policją okazały się śmiertelne. Takich osób jest całkiem sporo – w samych tylko Stanach Zjednoczonych w tym roku co najmniej 650 obywateli tego kraju zostało zastrzelonych przez policję. Artyści przywołują w swoim projekcie kilka faktów: w latach 2017–2021 jedną z głównych przyczyn śmierci w starciach z funkcjonariuszami policji były rany postrzałowe (70 proc.). I jeszcze jeden fakt, którego znaczenie wyjaśnimy za chwilę: w Chicago najwyższy wskaźnik śmierci z rąk policji dotyczył Afroamerykanów płci męskiej. Zgony zdarzały się średnio co 34 dni. „Zamiast ukazywać brutalność działań policji wyłącznie za pośrednictwem danych i statystyk, chcieliśmy pokazać ją poprzez relacje ofiar takich wydarzeń” – wyjaśniają czarnoskórzy artyści.

W głośnym przed dwoma dekadami filmie „Raport mniejszości”, w którym agent John Anderson z Agencji Prewencji, grany przez Toma Cruise’a, został uznany za przyszłego mordercę, przewidywaniem przyszłych zbrodni zajmowała się trójka jasnowidzów. Pracujący na zlecenie policji metodą prekognicji wskazywali na przyszłych sprawców przestępstw, dzięki czemu policja mogła ich złapać i ukarać, zanim jeszcze zrobili cokolwiek złego.

źródło: Syrena EG

Choć współczesna policja do tego samego używa dziś algorytmów karmionych danymi (np. zawierającymi informacje o lokalizacjach najczęściej popełnianych przestępstw czy listę dotychczasowych przestępców), efekty tego działania wydają się równie niedorzeczne jak w filmie. Nie chodzi tu tylko o błędy w kodzie samego oprogramowania predykcyjnego, choć takie też się zdarzają (np. w finansowanym przez rząd brytyjskim systemie Most Serious Violence [MSV], które miało pomóc policji w typowaniu, kto może popełnić przestępstwo, a okazało się szalenie mało precyzyjne). Przyczyną niepowodzeń bywają same algorytmy, które powielają ludzkie uprzedzenia rasowe, ekonomiczne oraz dotyczące płci (np. uprzedzenia wobec kobiet). Badacze z MIT Media Lab i Uniwersytetu Stanforda przeprowadzili badania trzech komercyjnych programów służących do identyfikowania twarzy wyprodukowanych przez wiodące firmy. Producenci oprogramowania zgodnie twierdzili, że ich produkt jest bardzo skuteczny. W istocie: błędne rozpoznawanie twarzy nie przekraczało 0,8 proc. wszystkich prób – w przypadku białych mężczyzn. Szkopuł w tym, że gdy chodziło o ciemnoskóre kobiety współczynnik błędu wynosił już 20–34 proc., a w niektórych przypadkach dochodził do nawet ponad 46 proc.

Z kolei wnioski z badań zebrane w raporcie amerykańskiego Narodowego Instytutu Standardów i Technologii (National Institute of Standards and Technology) pokazują, że przy rozpoznawaniu twarzy czynniki takie jak pochodzenie czy kolor skóry faktycznie wpływają na wzrost wskazań fałszywie pozytywnych, zwiększając ich odsetek od 10 do nawet 100 razy. Na straconej pozycji są również kobiety – w ich przypadku wskaźnik false positives jest od 2 do 5 razy większy niż w przypadku mężczyzn.

Trudno się dziwić, że coraz szersze wykorzystywanie sztucznej inteligencji przez policję w różnych krajach (głównie w Stanach Zjednoczonych i Wielkiej Brytanii) od lat budzi kontrowersje. Funkcjonariusze organów ścigania używają oprogramowania rozpoznającego twarze do egzekwowania prawa, jednak często odbywa się to bez odpowiedniego nadzoru i testów. Z tego powodu łatwo o pomyłki i błędy. Trudno o bardziej dosadny komentarz do tego zjawiska niż słowa Michelle Bachelet, komisarz ONZ ds. Praw Człowieka, która we wrześniu 2021 roku powiedziała w Genewie, że stosowanie sztucznej inteligencji, zwłaszcza w przypadku narzędzi do skanowania twarzy, które śledzą ludzi w przestrzeni publicznej, nie jest zgodne z prawami człowieka. Komentarze pojawiły się wraz z nowym raportem ONZ, analizującym nowe technologie w kontekście praw człowieka. „Stronnicze zbiory danych, na których opierają się systemy sztucznej inteligencji, mogą prowadzić do dyskryminujących decyzji, a te zagrożenia są najbardziej dotkliwe dla już zmarginalizowanych grup” – czytamy w dokumencie.

Mechanizm ten został ukazany w „Future Wake” bez żadnej taryfy ulgowej dla osób go stosujących. Algorytmy predykcyjne, których użyto w projekcie artystycznym zostały przeszkolone na podstawie informacji ze zbiorów danych Fatal Encounters i Mapping Police Violence, serwisów dokumentujących faktyczne zabójstwa dokonane przez policję w USA. Po usunięciu duplikatów danych, artyści wyodrębnili z tych zasobów opisy demograficzne, lokalizacyjne i wydarzenia – w ten sposób zbudowali modele predykcyjne dla pięciu głównych amerykańskich miast. Informacje, którymi karmiono algorytmy, zawierały dane o ponad 30 tysiącach ofiar z ostatnich 21 lat. Około jedna była trzecia (32 proc.) miała biały odcień skóry, 22 proc. było czarnoskórych, a 13 proc. stanowili Latynosi. – Chociaż liczby te reprezentują populację ofiar w populacji Stanów Zjednoczonych, odkryliśmy również, że w Chicago, Houston i Nowym Jorku większość ofiar była czarna. Jednak w Houston i Phoenix większość ofiar stanowili Latynosi – mówią artyści. W 2021 r. 26 proc. osób zabitych przez policję stanowiły osoby czarnoskóre, mimo że stanowią one tylko 13 proc. populacji. Wiek ofiar wahał się od mniej niż jednego roku do 102 lat.

Tim i Oz nie są jedynymi osobami zaskoczonymi ilością i różnorodnością tych informacji. – Jestem pewien, że gdybyś próbował znaleźć swojego sobowtóra demograficznego, nie miałbyś z tym problemu – mówi Oz. – W tym zbiorze danych reprezentowani są niemal wszyscy, jednak niektóre populacje są nadreprezentowane – dodaje.

Głośne porażki systemów rozpoznawania twarzy (projekt „Future Wake” poważa tylko jeden z aspektów działania tego rodzaju narzędzi) świadczą o jednym: w systemach zasilanych sztuczną inteligencją najważniejsze znaczenie ma jakość danych treningowych, nie zaś ilość. Dlatego w tym obszarze tak często dochodzi do dyskryminacji lub błędów dotyczących osób, których cechy były rzadziej reprezentowane w bazach danych, na których uczyły się algorytmy.

Systemy sztucznej inteligencji w naszym codziennym życiu mogą utrwalać i wzmacniać uprzedzenia, które od dawna istnieją w trybie offline. I nie chodzi tu tylko o systemy rozpoznawania twarzy błędnie identyfikujące czarne twarze, ale i wirtualnych asystentów, takich jak np. Alexa czy Siri, które mają trudności ze zrozumieniem „czarnych” głosów. Według naukowców z Uniwersytetu Standforda systemy głosowe Amazonu, IBM-u, Google’a, Microsoftu i Apple’a popełniają prawie dwa razy więcej błędów podczas interpretacji słów wypowiadanych przez Afroamerykanów niż osoby rasy białej. Jak widać, w miarę jak systemy sztucznej inteligencji będą stawać się coraz bardziej wyrafinowane i powszechne, problemy zaakcentowane w „Future Wake” będą się jeszcze bardziej nasilać.

Thomas Macaulay, Artists create AI that predicts who the police will kill next, serwis internetowy Thenextweb.com, [dostęp: 28.10.2021]

Cade Metz, There Is a Racial Divide in Speech-Recognition Systems, Researchers Say, serwis internetowy magazynu „The New York Times”, [dostęp: 28.10.2021]

Jonathan Greig, Mozilla artists question whether AI could predict police killings, serwis internetowy Zdnet.com, [dostęp: 28.10.2021]

Michał Rolecki, Raz, dwa trzy, zabijesz ty, czyli policyjny niewypał, serwis internetowy Sztucznainteligencja.org.pl, [dostęp: 28.10.2021]

Sztuczna inteligencja non-fictions, opracowanie Anny Obem i Katarzyny Szymielewicz, serwis internetowy Fundacji Panoptykon, [dostęp: 28.10.2021]