Zagęszczanie ruchów

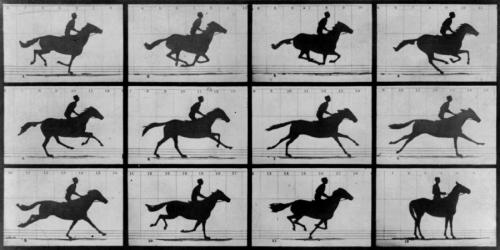

Historia motion capture zaczyna się tam, gdzie historia animacji. Jednym z jej kamieni milowych jest eksperyment Eadwearda Muybridge’a, który wywodzi się z... zakładu. Fotograf założył się ze swoim przyjacielem, że w pewnym momencie galopu koń odrywa od podłoża wszystkie kopyta, co – dzięki serii 12 zdjęć – udowodnił. Z racji czasów (1878 rok) wygrana wymagała kilkuletnich przygotowań, podczas których Muybridge skracał czas naświetlania fotografii.

Kolejny ważny rozdział spisał w 1915 Max Fleischer. Amerykanin polskiego pochodzenia opracował rotoskop, wynalazek, który zrewolucjonizował ówczesną animację. Fleischer stworzył urządzenie zdolne wyświetlać na papierze poszczególne klatki filmu, dzięki czemu animator mógł je odrysować (lub wykorzystać w ramach swobodnej inspiracji), przenosząc ruch klatka po klatce (dodajmy, że ówczesne filmy były kręcone z prędkością 16 klatek na sekundę). Z jego technologii skorzystał później Walt Disney, wykorzystując rotoskopię przy „Królewnie Śnieżce i siedmiu krasnoludkach”, rozwiązaniom Polaka zawdzięczamy również niektóre sekwencje klasycznych kreskówek z Popeye’em czy Betty Boop.

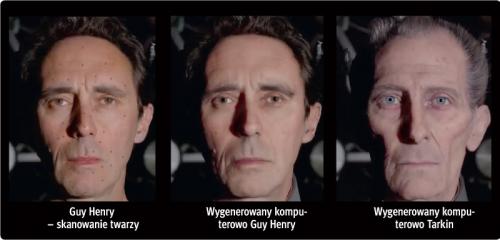

Rozwój motion capture oraz efektów CGI budzi nadzieje na „przywracanie do życia” dawno zmarłych aktorów. Po latach karkołomnych prób (że tylko wspomnimy odcinek „Rodziny Soprano”, w którym wykorzystano odrzuty z nagrań przedwcześnie zmarłej Nancy Marchand, które nałożono na ciało innej aktorki) sprawa wróciła na tapetę za sprawą ponownego występu Wielkiego Moffa Tarkina. Postać dobrze znana z klasycznej trylogii „Gwiezdnych wojen” w teorii nie mogła się pojawić w niedawnym „Łotrze 1”, bo wcielający się w nią Peter Cushing w 1994 przegrał walkę z rakiem. Skąd więc jego obecność w filmie datowanym na rok 2016?

Twarz aktora przeskanowano, posiłkując się nagraniami z „Nowej nadziei”, i nałożono cyfrowo na podobnej postury Guya Henry’ego, który drobiazgowo odtworzył mimikę zmarłego. Występ, choć technologicznie wyprzedzał wszystko, co widzieliśmy dotychczas, był jednak krytykowany zarówno przez wzgląd na jakość (gdy Tarkin otwierał usta, mięśnie twarzy nie poruszały się tak, jak powinny), względy etyczne, jak i... koszty. Źródła dziennika „The Guardian” wskazują, że „była to jedna z najbardziej kompleksowych i kosztownych rekreacji CGI w historii”. Sporo problemów dostarczyły ekipie… nogi zmarłego aktora, których nie było widać na żadnym z gwiezdnowojennych ujęć. „Trzeba było przejrzeć długie godziny starych horrorów (w których Cushing występował w całości – dop. red.), by odtworzyć jego sposób poruszania się” – mówił dziennikarzom jeden z pracowników wytwórni.

Do niedawna standardem było osobne rejestrowanie ruchu szkieletu, dłoni oraz mimiki i późniejsze ich „sklejanie”. Szczególnie problematyczna jest twarz: dawniej i na nią przyklejało się markery, które rejestrowały zmianę położenia jej najbardziej newralgicznych elementów (kącików oczu i ust, linii brwi). Coraz częściej sesje realizuje się jednak w technologii full performance capture, pozwalającej na jednoczesne nagrywanie kwestii mówionych, ruchu i grymasów (aktor zakłada specjalny kask z przytroczoną kamerą, a system „w locie” wychwytuje ruch istotnych mięśni).

Najbardziej problematyczne są, rzecz jasna, gry wideo. Poza przerywnikami filmowymi trzeba do nich nagrać chociażby tzw. idle, czyli zapętlone animacje, które wyświetlą się, gdy postać nie będzie się zajmować niczym konkretnym. Aktorzy drapią się wówczas po głowie, bujają i przestępują z nogi na nogę. W osobnych sesjach realizuje się choreografię walk, animację chodu, biegu czy skoku oraz reakcje na kwestie rozmówców. Podobną drobnicę najwięksi developerzy (w rodzaju Techlandu i CD Projekt Red) realizują we własnych, „domowych” pracowniach mocapowych. Ale gdy zaistnieje potrzeba nagrania załogantów miotających się po pokładzie tonącego okrętu (a tak właśnie zaczyna się Wiedźmin 2: Zabójcy królów), na okoliczność której trzeba podwiesić aktorów na linkach i wprowadzić na plan dźwig – przydaje się namiar na zewnętrznych fachowców.

Najbardziej problematyczne są, rzecz jasna, gry wideo. Poza przerywnikami filmowymi trzeba do nich nagrać chociażby tzw. idle, czyli zapętlone animacje, które wyświetlą się, gdy postać nie będzie się zajmować niczym konkretnym. Aktorzy drapią się wówczas po głowie, bujają i przestępują z nogi na nogę. W osobnych sesjach realizuje się choreografię walk, animację chodu, biegu czy skoku oraz reakcje na kwestie rozmówców. Podobną drobnicę najwięksi developerzy (w rodzaju Techlandu i CD Projekt Red) realizują we własnych, „domowych” pracowniach mocapowych. Ale gdy zaistnieje potrzeba nagrania załogantów miotających się po pokładzie tonącego okrętu (a tak właśnie zaczyna się Wiedźmin 2: Zabójcy królów), na okoliczność której trzeba podwiesić aktorów na linkach i wprowadzić na plan dźwig – przydaje się namiar na zewnętrznych fachowców.

Oczywiście nie wszystko da się zrobić w studiu motion capture. Kiepsko wychodzi np. mocap zwierząt. Na takie rozwiązanie decydują się najwięksi (np. Activision, które na okoliczność Call of Duty: Black Ops II zarejestrowało koński galop i cwał), ale oszczędniej jest postawić na „ręczną” animację, klatka po klatce. O mocapie zwierząt Perdjon mówi: – Wymaga to ogromnej przestrzeni, wytresowanych, oswojonych zwierząt, ogromnej dyscypliny i wielu dni pracy. W dodatku konie czy psy są kiepskimi aktorami.